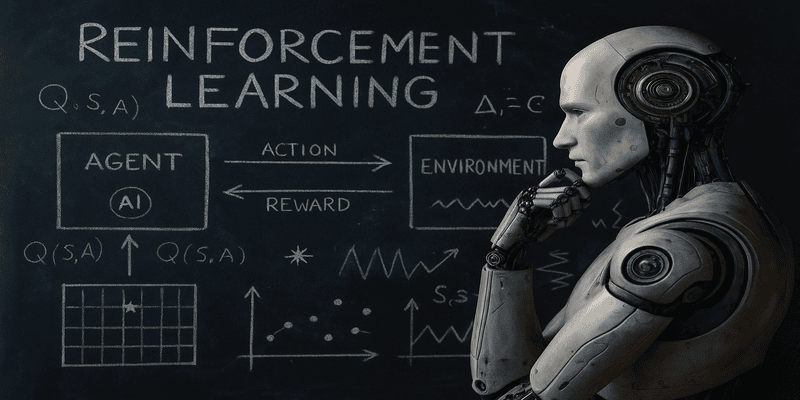

¿Qué es el Aprendizaje por refuerzo?

El aprendizaje por refuerzo es una técnica de IA donde un sistema aprende observando los resultados de sus acciones en un entorno dinámico. En lugar de entrenarse con grandes cantidades de datos etiquetados, como en el aprendizaje supervisado, el agente de RL interactúa directamente con el entorno y ajusta su comportamiento según las recompensas (positivas o negativas) que recibe. Este paradigma es ideal para problemas donde no hay una respuesta correcta inmediata, sino que el sistema debe aprender una estrategia óptima a largo plazo, como jugar un juego, navegar por un entorno o gestionar recursos. Es especialmente poderoso en tareas donde las acciones tienen consecuencias acumulativas.

Componentes

-

Agente: Es quien toma las decisiones. Puede ser un robot, un software, un dron, etc.

-

Entorno: Todo lo que rodea al agente, incluyendo las reglas y condiciones con las que debe interactuar.

-

Acciones: Opciones disponibles que el agente puede ejecutar en cada paso del proceso.

-

Estados: Representación de la situación actual del entorno desde la perspectiva del agente.

-

Recompensa: Valor numérico que recibe el agente tras realizar una acción; puede ser positiva (si hizo algo bien) o negativa (si cometió un error).

-

Política (policy): Es la estrategia que sigue el agente para elegir sus acciones según el estado actual.

-

Función de valor: Estima cuánto vale un estado o una acción, en función de las recompensas futuras que puede generar.

Estos elementos interactúan continuamente durante el proceso de aprendizaje para mejorar la toma de decisiones del agente.

Aplicaciones

-

Videojuegos: Algoritmos como AlphaGo o AlphaStar han superado a jugadores humanos en juegos extremadamente complejos. Estas tecnologías no solo dominan juegos, sino que también se usan para entrenar agentes virtuales en entornos simulados.

-

Robótica: Robots aprenden a caminar, conducir, manipular objetos o moverse en entornos impredecibles, usando RL para mejorar su comportamiento de forma continua.

-

Finanzas: Se usa para desarrollar estrategias de trading que se adaptan al comportamiento cambiante del mercado, optimizando el portafolio en tiempo real.

-

Salud: En medicina, RL se explora para ajustar tratamientos, como la dosificación de medicamentos en función de cómo responde el paciente.

Algoritmos populares

-

Q-Learning: Utiliza una tabla que guarda el valor de cada acción en cada estado. Es ideal para entornos simples y discretos.

-

SARSA: Similar a Q-Learning, pero tiene una diferencia clave: aprende la política que realmente se está siguiendo, lo que puede hacerlo más conservador y seguro en algunos casos.

-

Deep Q-Network (DQN): Extiende Q-Learning usando redes neuronales profundas para entornos donde los estados son muy complejos (como imágenes o juegos 3D).

-

Policy Gradient: En lugar de estimar valores, aprende directamente la política óptima mediante optimización de gradiente. Se usa en entornos con acciones continuas.

-

PPO (Proximal Policy Optimization): Uno de los algoritmos más modernos, usado por OpenAI y otros laboratorios. Logra gran estabilidad y rendimiento en entornos complejos como simulaciones físicas.

Cada algoritmo tiene su campo de aplicación y en muchos casos se combinan para obtener mejores resultados.

CONCLUSIÓN

El aprendizaje por refuerzo representa un paso significativo hacia sistemas inteligentes que pueden adaptarse, aprender de su entorno y mejorar con el tiempo sin intervención humana directa. Su versatilidad lo hace ideal para problemas dinámicos y de largo plazo. A medida que superamos los desafíos técnicos, veremos expandir su uso desde los laboratorios hasta la vida cotidiana: en autos, hogares, oficinas, salud y más.

- Debes estar logueado para realizar comentarios